CCMT机器翻译技术在线评测平台使用说明

-

关于本评测平台

本平台旨在提供第 二十一届全国机器翻译学术会议(CCMT

2025)的测评服务,通过web网站的形式对各参赛队伍上传的测试文件提供测评结果和积分排名,并将数据上传至数据库。

本测试平台实现的主要功能如下:

参赛队伍账号管理

提供测试集数据下载

参赛队伍创建MT系统及提交测试

对参赛队伍提交的系统进行自动评价,自动评价包含指标有:BLEU-SBP、BLEU-NIST、TER、METEOR、NIST、GTM、mWER、mPER以及ICT

查看当前各个任务的排名情况及排行榜

-

使用步骤

主办方会提供评测平台的账号给各参赛队伍/个人,每支参赛队伍/个人只有一个账号,可自行修改密码及相关信息。每个账户都可以对各任务提交评测,以CE为例,介绍评测流程:

1)创建一个用于评测的系统

点击创建新系统按钮,进入添加系统页面,填写系统相关信息,包括:系统名、所用软件技术、系统描述等等

2)选择评测数据集及系统

点击提交评测,进入选择页面,选择评测数据集及用户创建的系统

3)上传文件

上传所选测试集对应的机器翻译结果,文档格式需按照评测大纲中的说明要求,否则可能导致评测结果异常。

4)计算评测结果

文件上传完毕之后,后台会自动调用评测工具进行评分,计算过程与所选测试集大小有关,用户可在历史记录中查看得分详情。

-

注意事项

1)用户的个人信息仅主办方及用户本账户可见。但用户的单位信息将展示在排行榜的提交结果中,若不填则默认为空,请务必填写。

2)用户所创建的系统,其详细信息可在排行榜中被所有人查看,包括系统信息、系统提交记录、提交人等。

3)用户创建的系统会由系统分配系统id,在翻译结果中的sysid属性填写此id即可。特别注意:sysid为必填,setid必须与src中的setid一致,否则会评测失败。

4)单个用户可以创建多个系统,每个系统的提交次数、提交任务均不受限制,但对于某个任务,单个系统的多次提交,只取其最好成绩计入排行榜中。

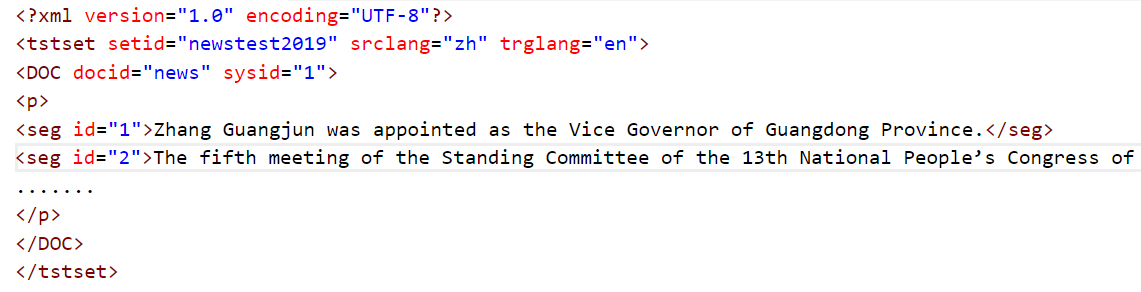

5)提交数据格式请务必按照评测要求,文件格式为xml,所提交翻译结果的根元素应为tstset,参考格式如下图: